Cursor 提供多种先进模型,包括最新的前沿模型。

# 模型

# 团队套餐定价

团队套餐的所有模型用量均按请求数统计和计费。Cursor 提供两种使用模式:

## 普通模式

**每模型/消息的请求数**

适用于日常编码任务,推荐大多数用户使用。

[Max模式:每百万 token (MTok) 最大请求数 | 专为复杂推理、疑难问题排查和代理任务设计](https://docs.cursor.com/context/max-mode)

# 请求

一个请求代表发送给模型的单条消息,包含您的消息、代码库中的相关上下文以及模型的响应。

单次请求费用为 $0.04

# 免费请求

当普通请求用尽时,系统会自动激活免费请求。这些请求处理优先级较低,因此响应可能比快速请求稍慢——但仍完全免费。

> 💡 Max模式不提供免费请求。

# 普通模式

在普通模式下,每条消息的成本仅基于所用模型固定消耗请求数,与上下文无关。我们会优化上下文管理且不影响您的请求计数。

例如,以下对话使用 Claude 3.5 Sonnet 模型,每条消息消耗 1 次请求:

|:---|:---|:---|

| 用户 | 为此变更创建计划(使用更昂贵的模型) | 1 |

| Cursor | 我将分析需求并制定详细实施计划... | 0 |

| 用户 | 使用 TypeScript 实现变更并添加错误处理 | 1 |

| Cursor | 这是包含类型安全和错误处理的实现... | 0 |

| **总计** | | **2 次请求** |

# Max模式

在 [Max模式](https://docs.cursor.com/context/max-mode) 下,定价基于 token 计算,Cursor 按模型提供商的 API 价格加收 20% 服务费。费用包含消息、代码文件、文件夹、工具调用及所有其他提供给模型的上下文 token。

> 💡 我们使用与模型提供商相同的 token 计数器(如 GPT 模型用 OpenAI 计数器,Claude 模型用 Anthropic 计数器)确保计数准确。您可通过 [OpenAI 的 token 计数器示例](https://platform.openai.com/tokenizer) 查看演示。

Max模式计费示例如下:

|:---|:---|:---|:---|:---|

| 用户 | 为此变更创建计划(使用更昂贵的模型) | 135k | 无缓存输入 token | 2.7 次请求 |

| Cursor | 我将分析需求并制定详细实施计划... | 82k | | 1.23 次请求 |

| 用户 | 使用 TypeScript 实现变更并添加错误处理 | 135k | 大部分输入 token 已缓存 | 2.7 次请求 |

| Cursor | 这是包含类型安全��和错误处理的实现... | 82k | | 1.23 次请求 |

| **总计** | | 434k | | **7.86 次请求** |

---

- 概览

- 团队套餐定价

---

## 模型列表

### Claude 4 Sonnet

#### 普通模式

- **提供商**: Anthropic

- **链接**: [Claude 4 Sonnet](https://www.anthropic.com/claude/sonnet)

- **上下文窗口**: 120k

- **能力**: 代理(可使用工具)、思考(消耗推理 token)

- **成本**: 1 次请求/消息

- **备注**: 当前慢速池不可用

#### 变体

- **思考版**:

成本: 2 次请求/消息

#### Max模式

- **提供商**: Anthropic

- **链接**: [Claude 4 Sonnet](https://www.anthropic.com/claude/sonnet)

- **上下文窗口**: 200k

- **能力**: 代理(可使用工具)、思考(消耗推理 token)

- **输入成本**: 90 次请求/MTok

- **缓存输入成本**: 9 次请求/MTok

- **输出成本**: 450 次请求/MTok

(后续模型信息按相同规则翻译,此处因篇幅限制省略详细内容)

---

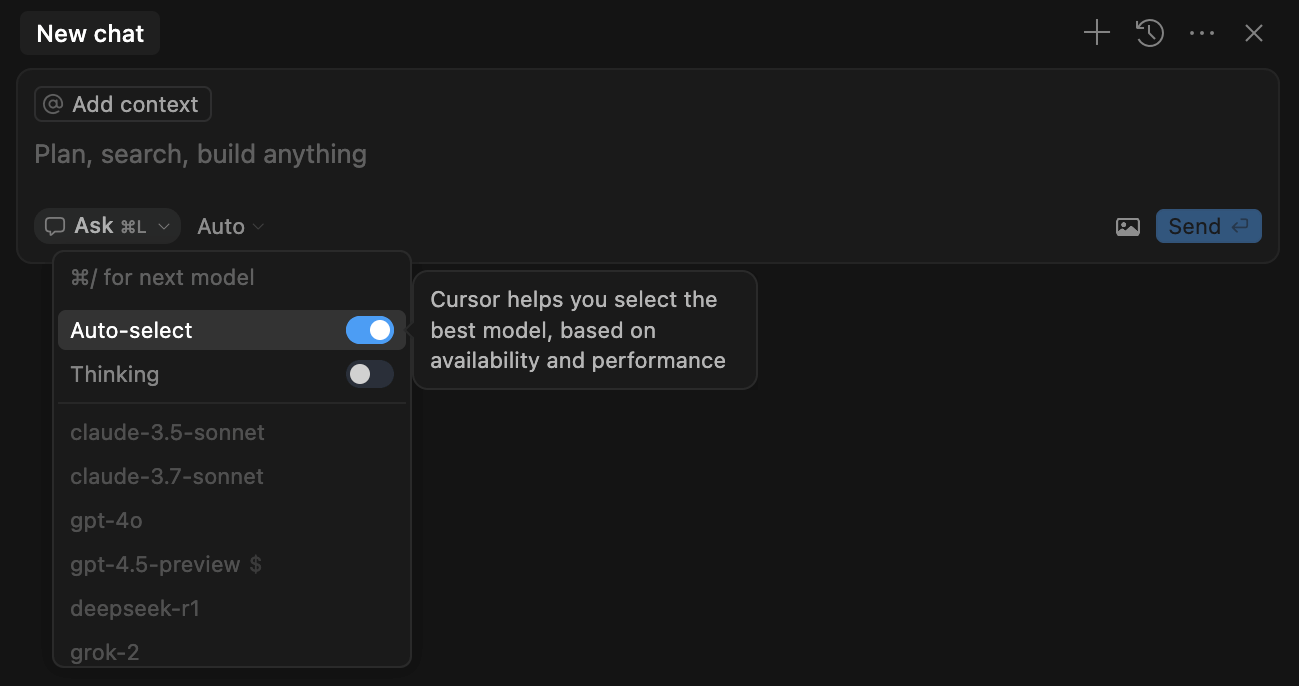

# 自动选择

启用"自动选择"后,Cursor 会根据当前任务需求和系统负载,自动选用最适合的高级模型。此功能可检测输出质量下降并自动切换模型解决问题。

> 💡 推荐大多数用户使用

# 能力说明

## 思考模式

启用思考模式将限定使用具备逐步推理能力的模型,这些模型能深度检查自身推理过程并修正错误。

此类模型在复杂任务中表现更优,但响应时间可能较长。

## Max模式

部分模型支持 Max 模式,专为最复杂的任务设计。Max 模式会更快消耗用量限额。[了解 Max 模式详情](https://docs.cursor.com/context/max-mode)

# 上下文窗口

上下文窗口指模型单次处理的最大 token 容量(含输入提示和模型输出)。

Cursor 中每个聊天会话独立维护上下文窗口。会话中的提示、附件和响应越多,上下文窗口越大。

Cursor 会动态优化上下文窗口,智能剔除非必要内容同时保留关键代码和对话要素。

建议采用任务导向的会话管理方式,为不同任务开启新会话。

# 托管服务

模型托管于美国基础设施,由模型提供商、可信合作伙伴或 Cursor 运营。

在设置中启用隐私模式后,Cursor 和模型提供商均不会存储您的数据,所有数据在处理后立即删除。详见我们的[隐私说明](https://www.cursor.com/privacy-overview)、[隐私政策](https://cursor.com/privacy)和[安全页面](https://cursor.com/security)。