下载模型

集成库

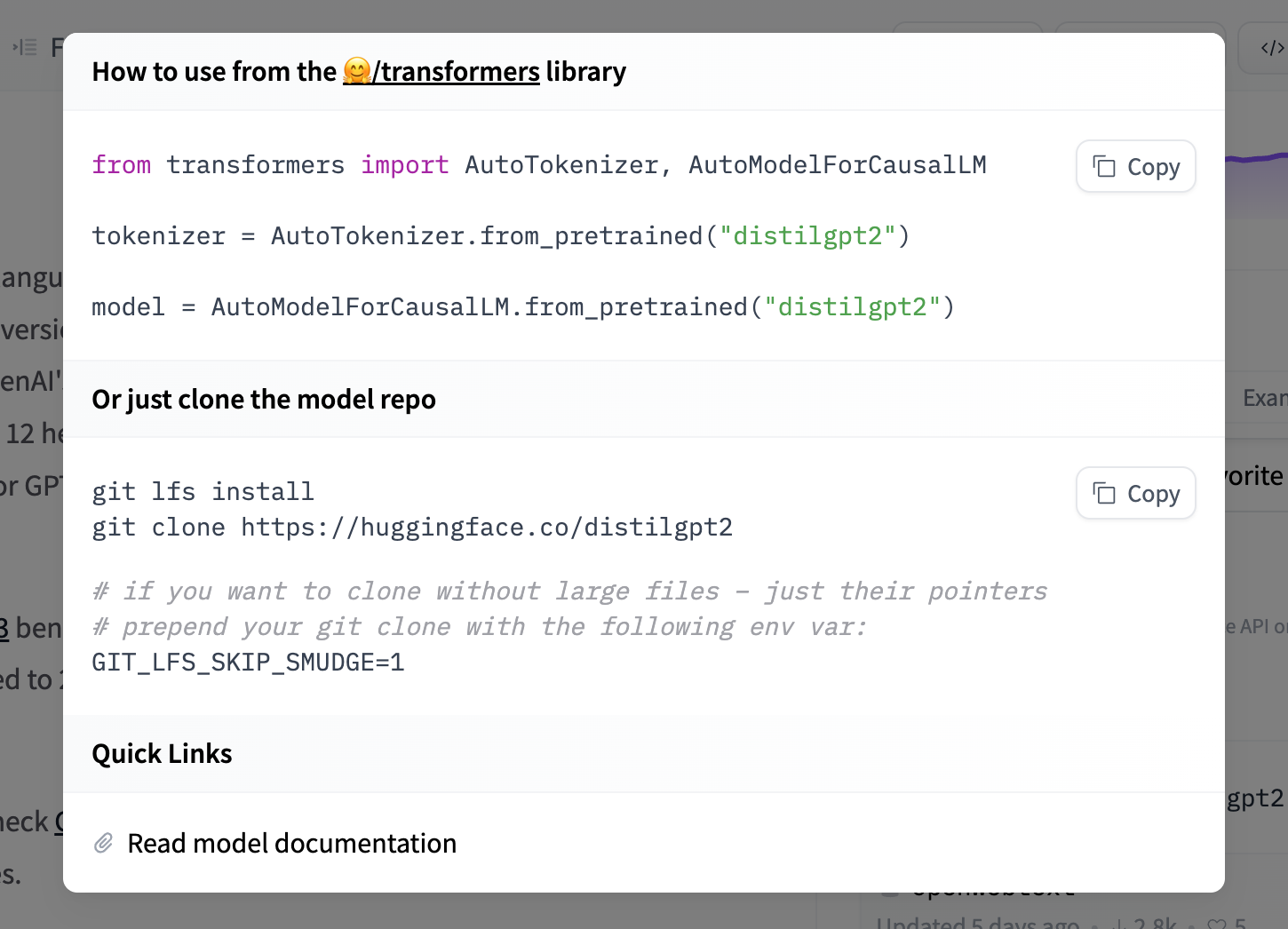

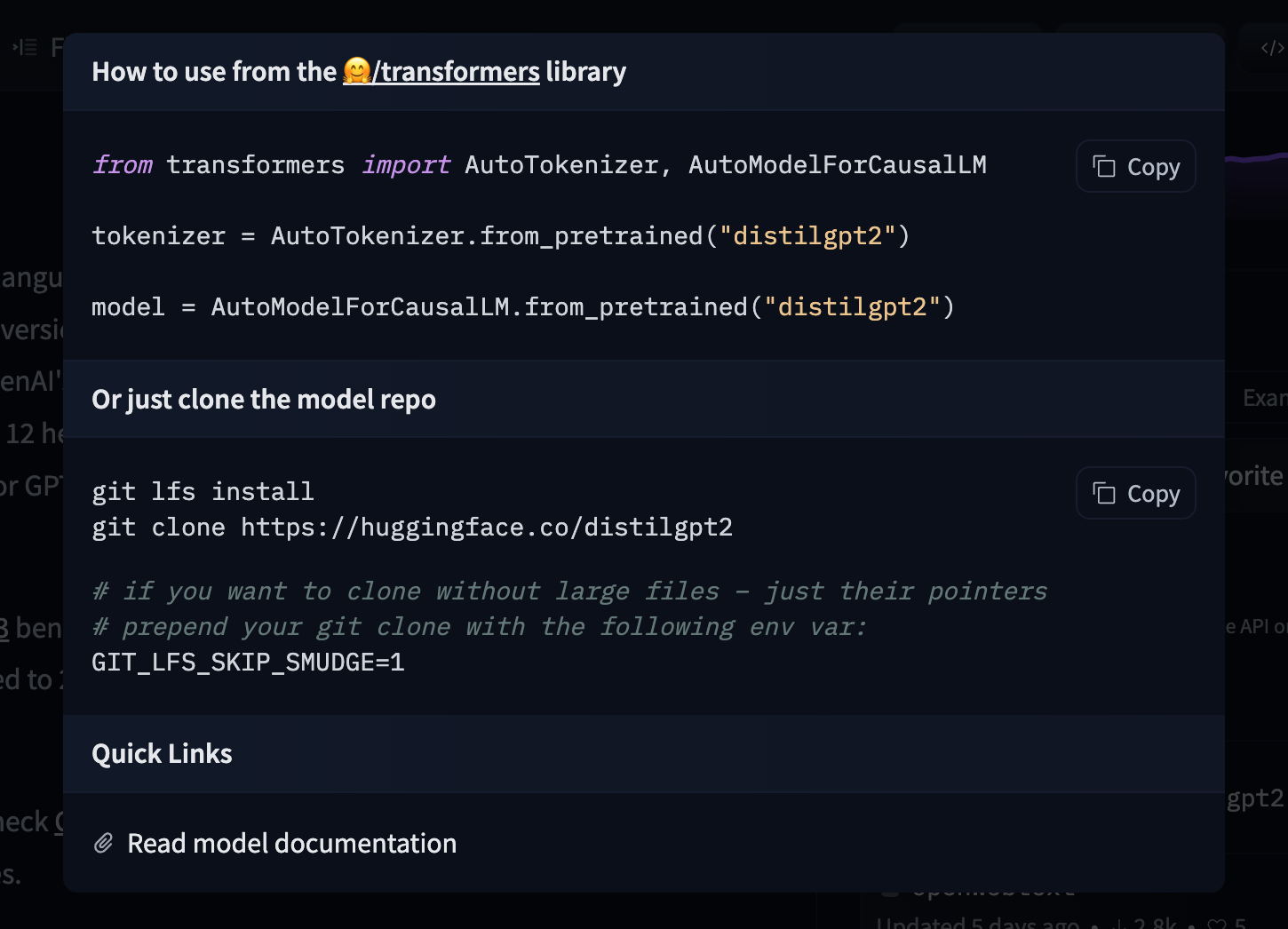

如果 Hub 上的模型与支持的库相关联,只需几行代码即可加载模型。有关访问模型的信息,你可以点击模型页面上的"在 Library 中使用"按钮查看如何操作。例如,distilbert/distilgpt2 下面显示了如何使用 🤗 Transformers 进行操作。

使用 Hugging Face 客户端库

你可以使用 huggingface_hub 库来创建、删除、更新和检索仓库信息。例如,要从命令行下载 HuggingFaceH4/zephyr-7b-beta 模型,请运行

hf download HuggingFaceH4/zephyr-7b-beta

有关更多信息,请参阅 CLI 下载文档。

你也可以将其集成到你自己的库中。例如,你可以用几行代码快速加载 Scikit-learn 模型。

from huggingface_hub import hf_hub_download

import joblib

REPO_ID = "YOUR_REPO_ID"

FILENAME = "sklearn_model.joblib"

model = joblib.load(

hf_hub_download(repo_id=REPO_ID, filename=FILENAME)

)

使用 Git

由于模型中心上的所有模型都是 Git 仓库,你可以通过运行以下命令在本地克隆模型:

git lfs install

git clone [email protected]:<MODEL ID> # 示例:git clone [email protected]:bigscience/bloom

如果你对特定模型仓库具有写入权限,你还可以提交和推送对模型的修订。

将你的 SSH 公钥添加到你的用户设置以推送更改和/或访��问私有仓库。

更快的下载

如果你在具有高带宽的机器上运行,

可以通过允许 hf_xet 在所有 CPU 核心上运行来加速下载。hf_xet 是一个基于 Rust 的包,利用新的 Xet 存储后端通过基于块的去重来优化文件传输。hf_xet 默认启用,但性能较低,以避免占用可用 CPU 和带宽,这可能会降低用户体验。

pip install -U huggingface_hub

HF_XET_HIGH_PERFORMANCE=1 hf download ...