在 Hugging Face 使用 PaddleNLP

利用 PaddlePaddle 框架,PaddleNLP 是一个易于使用且功能强大的 NLP 库,拥有出色的预训练模型库,支持从研究到工业应用的广泛 NLP 任务。

在 Hub 上探索 PaddleNLP

你可以通过在模型页面左侧筛选来找到 PaddleNLP 模型。

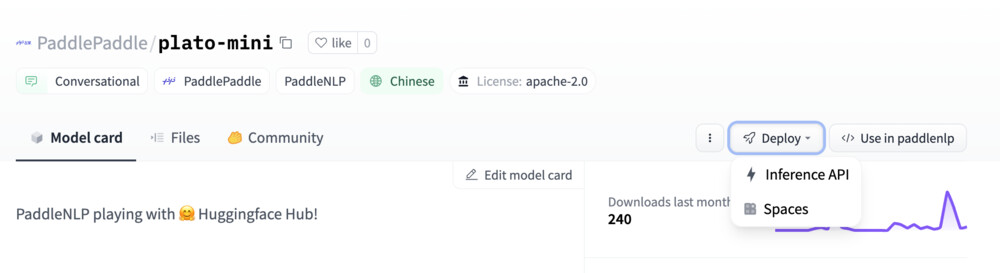

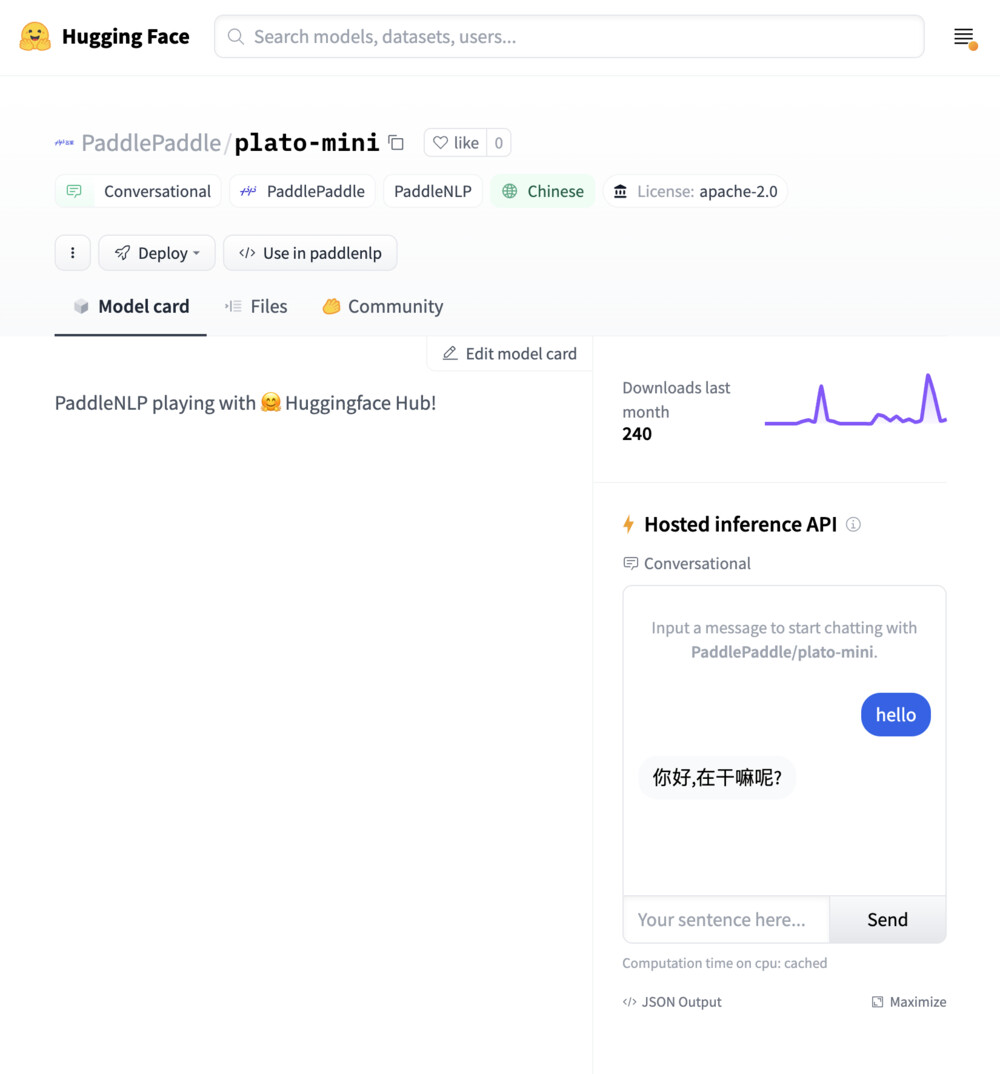

Hub 上的所有模型都配备了以下功能:

- 自动生成的模型卡片,包含简要描述和有助于可发现性的元数据标签。

- 一个交互式小部件,你可以直接在浏览器中使用模型。

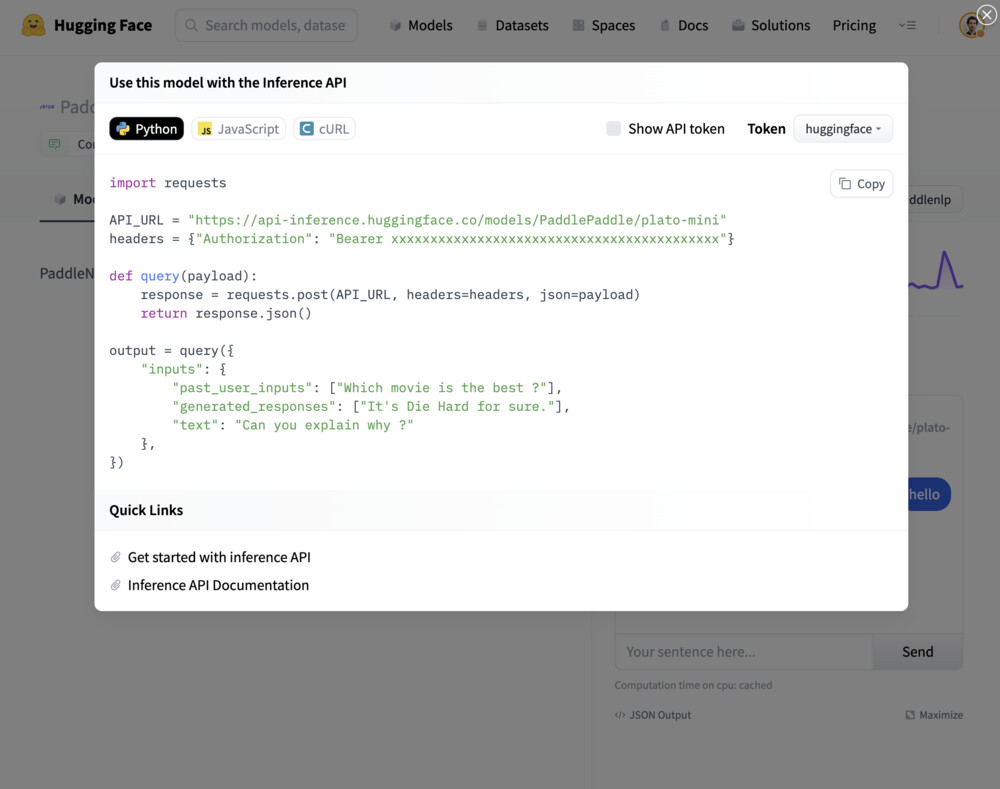

- 允许进行推理请求的推理 API。

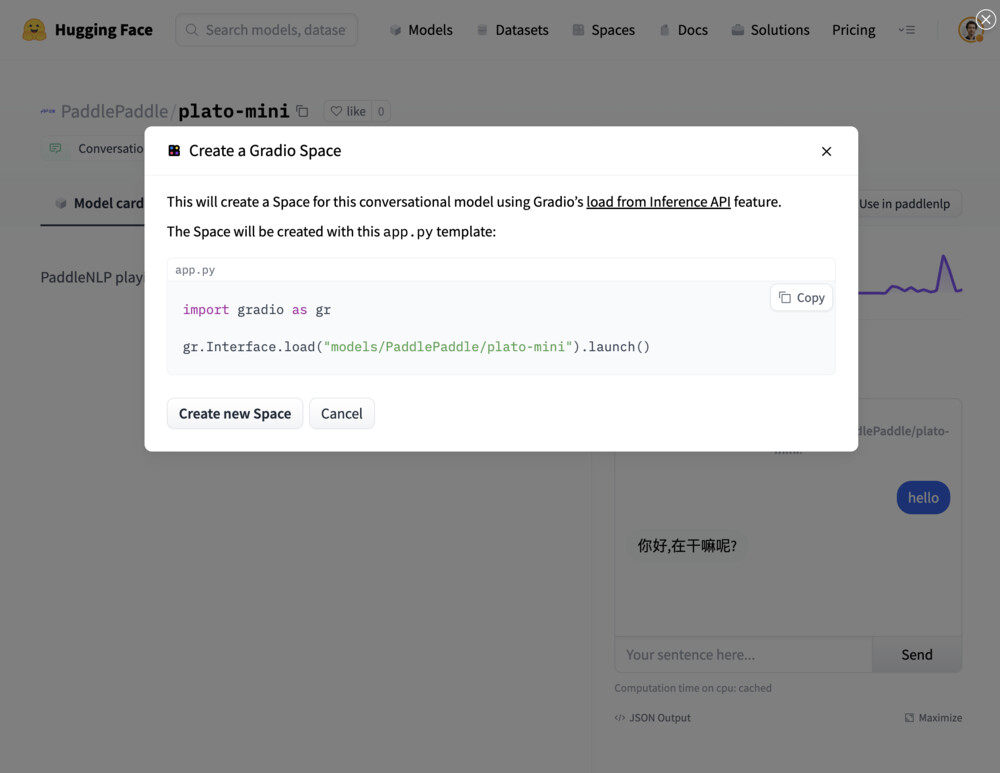

- 轻松将模型部署为 Spaces 上的 Gradio 应用。

安装

要开始使用,你可以遵循 PaddlePaddle 快速开始使用你喜欢的操作系统、包管理器和计算平台安装 PaddlePaddle 框架。

paddlenlp 通过 pip 提供快速的一行安装:

pip install -U paddlenlp

使用现有模型

与 transformer 模型类似,paddlenlp 库通过设置 from_hf_hub=True 提供简单的一行代码从 Hugging Face Hub 加载模型!根据你想如何使用它们,你可以使用高级 API(使用 Taskflow 函数)或使用 AutoModel 和 AutoTokenizer 以获得更多控制。

# Taskflow provides a simple end-to-end capability and a more optimized experience for inference

from paddlenlp.transformers import Taskflow

taskflow = Taskflow("fill-mask", task_path="PaddlePaddle/ernie-1.0-base-zh", from_hf_hub=True)

# If you want more control, you will need to define the tokenizer and model.

from paddlenlp.transformers import AutoTokenizer, AutoModelForMaskedLM

tokenizer = AutoTokenizer.from_pretrained("PaddlePaddle/ernie-1.0-base-zh", from_hf_hub=True)

model = AutoModelForMaskedLM.from_pretrained("PaddlePaddle/ernie-1.0-base-zh", from_hf_hub=True)

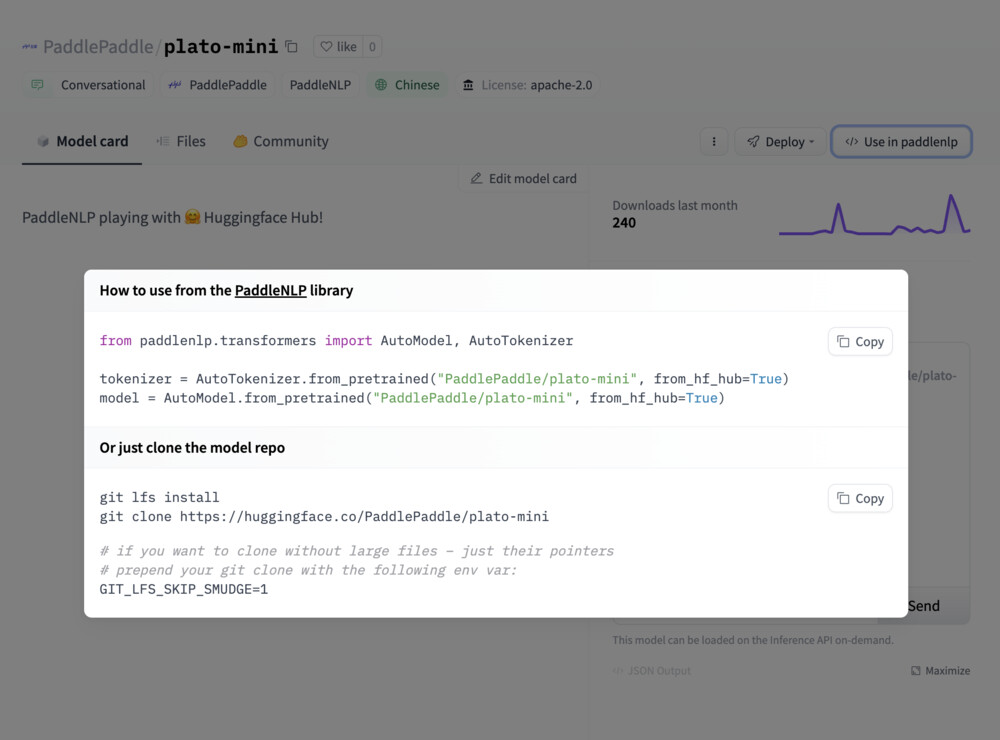

如果你想查看如何加载特定模型,可以点击 Use in paddlenlp,你将获得一个可用的代码片段来加载它!

分享你的模型

你可以使用所有 Model 和 Tokenizer 类下的 save_to_hf_hub 方法分享你的 PaddleNLP 模型。

from paddlenlp.transformers import AutoTokenizer, AutoModelForMaskedLM

tokenizer = AutoTokenizer.from_pretrained("PaddlePaddle/ernie-1.0-base-zh", from_hf_hub=True)

model = AutoModelForMaskedLM.from_pretrained("PaddlePaddle/ernie-1.0-base-zh", from_hf_hub=True)

tokenizer.save_to_hf_hub(repo_id="<my_org_name>/<my_repo_name>")

model.save_to_hf_hub(repo_id="<my_org_name>/<my_repo_name>")

其他资源

- PaddlePaddle 安装指南。

- PaddleNLP GitHub 仓库。

- Hugging Face Hub 上的 PaddlePaddle